De la Compréhension du Langage Naturel aux Agents Intelligents

Exploiter l’IA et les Modèles de Langage pour transformer les entreprises

Ecrit par Vincent

L’IA et les Modèles de Langage

L’intelligence artificielle (IA) a profondément changé la façon dont les entreprises interagissent avec la technologie et gèrent leurs processus internes. Au cœur de cette révolution se trouvent les modèles de langage, qui permettent aux machines de comprendre, de générer et d’interagir avec le langage humain de manière sophistiquée.

Les modèles de langage, qu’ils soient de petite (SLM) ou de grande taille (LLM), sont des algorithmes entraînés sur de vastes corpus de texte pour prédire et générer du langage humain cohérent. Ils constituent le fondement de nombreuses applications d’IA, allant des chatbots aux systèmes de traduction automatique. L’intégration de ces modèles dans les processus d’entreprise peut améliorer l’efficacité, réduire les coûts et offrir de nouvelles opportunités d’interaction avec les clients et les collaborateurs.

Dans cet article, nous allons explorer trois approches majeures de l’intégration des modèles de langage dans le monde de l’entreprise. Premièrement, nous aborderons le traitement du langage naturel avec les LLM, où les modèles de langage de grande taille sont utilisés pour automatiser et améliorer diverses tâches linguistiques sans nécessiter de connaissances spécifiques préalables. Ensuite, nous examinerons les RAG (Retrieval Augmented Generation) avec l’intégration d’une base de connaissances, qui enrichissent les capacités des LLM en leur fournissant un contexte précis pour des réponses plus pertinentes et personnalisées. Enfin, nous nous pencherons sur les agents intelligents autonomes, une approche avancée où les LLM sont combinés avec des processus de prétraitement et des outils externes pour exécuter des tâches complexes de manière autonome. Ces trois approches illustrent l’évolution progressive des applications de l’IA dans le traitement du langage, offrant aux entreprises des opportunités croissantes pour optimiser leurs opérations et interactions avec leurs clients et collaborateurs.

Traitement du Langage Naturel avec les LLM

Applications

Les modèles de langage de grande taille (LLM) peuvent être utilisés pour automatiser et améliorer divers processus liés au langage, sans nécessiter de connaissances spécifiques préexistantes. Voici quelques applications clés :

- Génération et Réécriture de Contenu : Création automatique d’articles, de descriptions de produits, adaptation du ton ou du style pour correspondre à une audience spécifique.

- Réduction et Augmentation de Texte : Résumer des documents volumineux ou développer des idées succinctes en textes détaillés.

- Traitement de Données et Scraping Intelligent : Extraction et structuration d’informations pertinentes à partir de sources non structurées.

- Anonymisation : Suppression ou modification des informations personnelles pour respecter la confidentialité.

- Qualification Automatisée (CRM) : Catégorisation et priorisation des leads ou des demandes clients.

- Routage de Mail Intelligent : Distribution automatique des emails aux bons services ou personnes.

- Détection de Spam : Identification et filtrage des communications indésirables.

- Traduction et Optimisation SEO : Traduction de contenu tout en optimisant pour les moteurs de recherche.

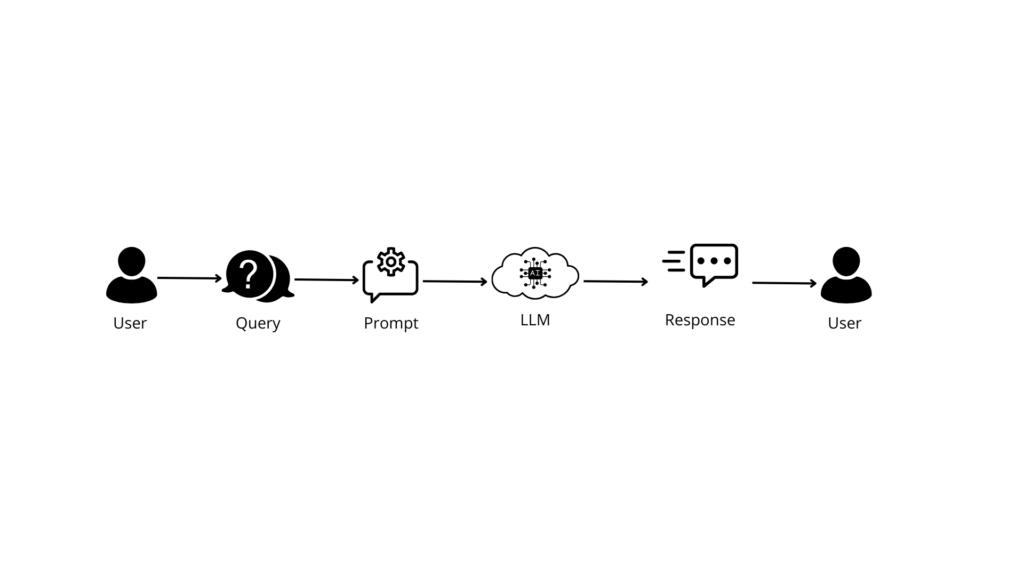

Architecture Technique

Schéma Simplifié :

Description :

- Entrée Utilisateur : L’utilisateur fournit une requête textuelle.

- Prétraitement (Prompting) : La requête peut être modifiée ou enrichie pour guider le modèle vers une réponse souhaitée.

- LLM : Le modèle de langage traite la requête et génère une réponse appropriée.

- Sortie : La réponse est renvoyée à l’utilisateur.

Défis

- Qualité et Pertinence des Réponses :

- Compréhension du Contexte Limité : Les LLM peuvent manquer de contexte spécifique, ce qui peut entraîner des réponses générales ou inexactes.

- Gestion des Ambiguïtés : Difficulté à interpréter correctement les requêtes ambiguës ou mal formulées.

- Coûts Computationnels Élevés :

- Ressources Matérielles : Besoin de matériel puissant pour l’inférence en temps réel.

- Optimisation des Modèles : Nécessité de techniques pour réduire la taille des modèles sans perte de performance.

- Latence et Temps de Réponse :

- Vitesse de Traitement : Les modèles volumineux peuvent entraîner des temps de réponse plus longs.

- Scalabilité : Gestion des requêtes simultanées sans dégradation des performances.

- Contrôle du Contenu Généré :

- Risques de Biais : Les modèles peuvent refléter des biais présents dans les données d’entraînement.

- Génération de Contenu Inapproprié : Possibilité de produire des réponses offensantes ou inexactes.

- Personnalisation et Adaptabilité :

- Fine-Tuning : Besoin d’adapter le modèle aux spécificités de l’entreprise.

- Maintenance : Mise à jour régulière des modèles pour intégrer de nouvelles données.

Les RAG : Intégration d’une Base de Connaissances

Applications

En ajoutant une base de connaissances aux LLM, on obtient des systèmes capables de fournir des réponses plus précises et contextualisées :

- Chatbots d’Entreprise : Assistance aux employés en répondant aux questions sur les politiques internes.

- Support Service Client : Réponse aux demandes des clients en utilisant des informations sur les produits et services.

- Interrogation de Bases de Connaissances : Accès simplifié à des informations complexes ou techniques.

- Génération de Documents Simples : Création automatique de comptes-rendus, synthèses ou suivis clients.

- Formation : Fourniture de matériel éducatif personnalisé.

- Moteur de Recherche Intelligent : Fourniture de résultats pertinents basés sur l’intention de l’utilisateur.

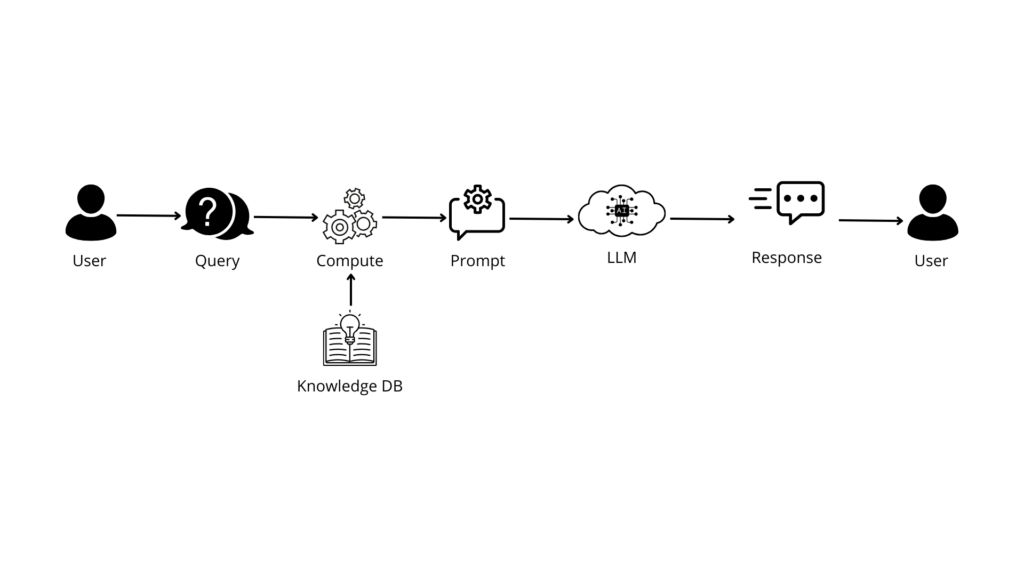

Architecture Technique

Schéma Simplifié :

Description :

- Entrée Utilisateur : Requête textuelle spécifique.

- Recherche dans la Base de Connaissances : Extraction d’informations pertinentes.

- Prétraitement : Formatage des données extraites pour intégration au prompt.

- Prompt Enrichi : Combinaison de la requête initiale et des informations de la base.

- LLM : Génération de la réponse en tenant compte du contexte supplémentaire.

- Sortie : Réponse contextualisée fournie à l’utilisateur.

Défis

- Intégration Efficace des Données :

- Alignement des Formats de Données : Assurer la compatibilité entre la base et le LLM.

- Gestion du Volume de Données : Traitement efficace de grandes quantités d’informations.

- Actualisation et Maintenance de la Base de Connaissances :

- Mises à Jour Régulières : Maintenir les informations à jour.

- Gestion des Conflits d’Informations : Résoudre les incohérences ou contradictions.

- Complexité du Prompting et de la Contextualisation :

- Limites de la Longueur du Contexte : Capacité limitée du LLM pour le contexte.

- Préservation de la Pertinence : Sélectionner les informations les plus pertinentes.

- Performance et Latence :

- Temps de Recherche : Optimiser la vitesse d’extraction des informations.

- Traitement en Temps Réel : Éviter l’augmentation de la latence.

- Sécurité et Confidentialité :

- Accès Non Autorisé : Protéger la base contre les accès non autorisés.

- Contrôle d’Accès Granulaire : Permissions pour gérer l’accès aux informations.

- Qualité et Fiabilité des Réponses :

- Propagation d’Erreurs : Les erreurs dans la base peuvent entraîner des réponses incorrectes.

- Validation des Informations : Mécanismes pour vérifier la véracité des données.

- Expérience Utilisateur :

- Personnalisation : Adapter les réponses au profil de l’utilisateur.

- Interface Conviviale : Concevoir des interfaces facilitant l’interaction.

- Scalabilité :

- Gestion de la Charge : Capacité à gérer un volume croissant d’utilisateurs.

- Infrastructure Flexible : Ajuster les ressources en fonction de la demande.

Les Agents Intelligents : Vers l’Autonomie

Applications

En intégrant du prétraitement et des outils supplémentaires, les agents intelligents peuvent exécuter des tâches complexes de manière autonome :

- Exécution de Tâches Complexes : Automatisation de processus nécessitant plusieurs étapes.

- Génération de Documents Avancés : Création de rapports détaillés, analyses et recommandations.

- Prise de Décision : Assistance en fournissant des analyses basées sur des données.

- Processus Autonomes ou Semi-Autonomes : Gestion de flux de travail sans intervention humaine constante.

Architecture Technique

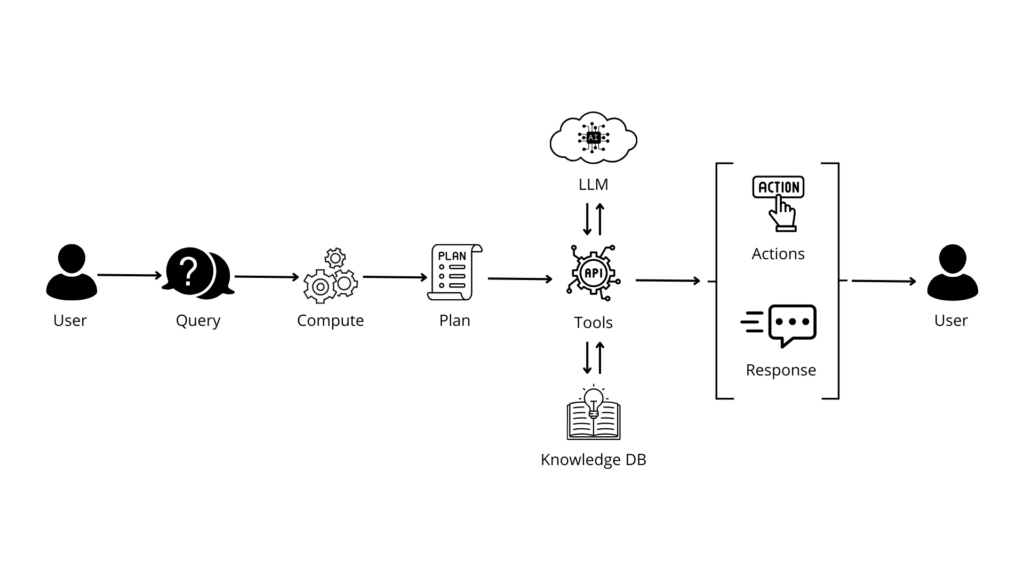

Schéma Simplifié :

Description :

- Entrée Utilisateur : Requête complexe impliquant plusieurs actions.

- Prétraitement Avancé : Analyse pour comprendre et décomposer la tâche.

- Planification : Élaboration d’un plan d’action ou d’une série d’étapes.

- Accès aux Outils Externes : Interaction avec des API, services web, bases de données.

- Base de Connaissances : Utilisation de données internes pour enrichir le contexte.

- LLM : Intervient à différentes étapes pour interpréter, décider et générer du contenu.

- Boucle de Rétroaction : L’agent apprend des interactions précédentes.

- Sortie/Action : Exécution de tâches, génération de documents complexes, prise de décision.

Défis

- Complexité de l’Orchestration et de la Coordination :

- Gestion des Flux de Travail : Coordination entre le LLM, les outils et les bases.

- Synchronisation : Assurer le fonctionnement harmonieux des composantes.

- Fiabilité et Robustesse :

- Gestion des Exceptions : Capacité à gérer les erreurs imprévues.

- Résilience : Maintien des performances en cas de défaillance.

- Sécurité Opérationnelle :

- Contrôle des Actions Automatisées : Éviter les actions non désirées.

- Auditabilité : Traçabilité des décisions pour conformité et transparence.

- Gestion des Données Sensibles :

- Confidentialité : Protection des informations manipulées.

- Conformité Légale : Respect des réglementations lors du traitement.

- Apprentissage et Adaptabilité :

- Apprentissage Continu : Mise à jour du modèle avec de nouvelles données.

- Évitement de la Dérive : Prévenir la détérioration des performances.

- Intégration avec les Systèmes Externes :

- Compatibilité : Interaction avec divers outils, API et services.

- Sécurité des Intégrations : Protéger les communications contre les interceptions.

- Expérience Utilisateur Avancée :

- Interaction Naturelle : Échanges fluides et intuitifs avec l’utilisateur.

- Personnalisation Profonde : Adaptation aux préférences spécifiques.

- Scalabilité et Performance :

- Optimisation des Ressources : Gestion efficace pour maintenir les performances.

- Réactivité : Temps de réponse rapides pour des tâches complexes.

Conclusion

L’évolution des modèles de langage offre des opportunités sans précédent pour les entreprises, allant de l’automatisation de tâches simples à la création d’agents intelligents autonomes. Chaque niveau d’intégration présente ses propres défis, qu’ils soient techniques, éthiques ou liés à l’expérience utilisateur. Il est essentiel pour les entreprises de comprendre ces défis afin de les surmonter et de tirer pleinement parti des avantages offerts par l’IA.

L’avenir de l’IA et des modèles de langage est prometteur. Avec l’avancement continu des technologies, nous pouvons anticiper des systèmes encore plus intelligents, capables de comprendre et d’interagir avec le monde de manière plus humaine. Les entreprises qui adopteront tôt ces technologies seront mieux placées pour innover, améliorer leur efficacité opérationnelle et offrir une valeur ajoutée à leurs clients.

Eurelis se positionne comme un partenaire de confiance pour accompagner les entreprises dans cette transformation. Avec notre expertise en intelligence artificielle et en intégration de modèles de langage, nous aidons nos clients à concevoir des architectures robustes, à relever les défis techniques et à intégrer l’IA de manière éthique et sécurisée dans leurs applications et processus. Ensemble, nous pouvons transformer ces défis en opportunités, propulser votre organisation vers l’avenir et façonner un monde où l’intelligence artificielle est un moteur de croissance et de succès.