Révolutions de l’IA

Opportunités du Couplage entre les LLM et les BDD Vectorielles

Ecrit par Chaima & Vincent

Même avec leurs capacités actuelles limitées et leurs défauts profonds, les utilisateurs trouvent des moyens d’exploiter les outils avancés de l’IA pour obtenir de grands gains de productivité, tout en comprenant bien leurs limitations. Les utilisateurs comprennent souvent mieux les outils et leurs limites que ce que nous leur expliquons.

Sam Altman, CEO of OpenAI

Les modèles de Langage à Grande Échelle (LLMs), dont nous avons discuté en détail dans l’article précédent, sont des outils puissants, capables de répondre de manière convaincante à une variété de questions. Cependant, cette capacité à fournir des réponses plausibles peut parfois présenter des défis !

Défis et limitations des LLMs ?

En effet, bien que les réponses de ces modèles semblent la plupart du temps logiques et bien fondées, elles contiennent parfois des informations incorrectes. Cette imprécision peut résulter de plusieurs facteurs, notamment l’absence de certains documents dans le corpus d’apprentissage (ensemble des textes et données utilisés pour entraîner le modèle). Les modèles peuvent aussi interpréter de manière erronée des données complexes, ce qui mène alors à des conclusions incorrectes. Le tableau suivant illustre les divers risques et limitations auxquels un LLM peut être confronté :

| Risques | Description |

|---|---|

| Informations obsolètes | Le LLM peut fournir des réponses basées sur des informations obsolètes, car il ne peut pas accéder aux données les plus récentes. |

| Inexactitudes/ Désinformation | Sans vérification auprès de sources fiables et actualisées, le LLM peut propager des informations erronées. |

| Manque de précision | Le LLM peut manquer du contexte spécifique nécessaire pour apporter des réponses précises et adaptées. |

| Biais | Les réponses peuvent refléter les biais présents dans les données d’entraînement initiales, sans possibilité de les corriger par des sources actuelles. |

| Hallucinations | Le modèle peut fournir des réponses qui sont incorrectes, même si elles sont formulées de manière convaincante. |

Par conséquent, il est important d’effectuer une vérification humaine régulière, d’utiliser des architectures et systèmes spécialisés, et de mettre à jour constamment le corpus d’apprentissage pour inclure les informations les plus récentes.

Ce dernier point est crucial pour les applications basées sur les LLM déployées dans des contextes avec des besoins spécifiques, appelées souvent « applications à usage intensif de connaissances », comme les chatbots spécialisés. Dans ces contextes, l’objectif principal est d’accéder à des sources d’information contrôlées et vérifiées. L’idée est de tirer parti de la capacité des LLMs à comprendre et synthétiser l’information, tout en s’appuyant sur une base de connaissances contrôlée et en citant les sources. Cette approche est rendue possible grâce aux RAG !

Qu’est-ce qu’un RAG ?

Un RAG, ou Retrieval Augmented Generation, est une architecture qui intègre plusieurs composants pour optimiser la recherche d’information. Ce système utilise principalement des LLMs pour explorer un corpus contrôlé par l’utilisateur, en récupérant uniquement des informations pertinentes. Ensuite, il synthétise ces éléments pour fournir une réponse cohérente et précise. En combinant la puissance des modèles de langage pour comprendre et générer du texte avec des capacités avancées de recherche, un RAG garantit des réponses à jour et contextuellement appropriées.

Principaux composants d’un RAG

L’architecture d’un RAG repose sur plusieurs composants avec différentes optimisations possibles. Nous présentons ici-après les composants de base.

Module d’encodage (encoder)

L’encodeur convertit la requête initiale et les documents récupérés en représentations vectorielles (embeddings) qui peuvent être utilisées par le retriever et le générateur. L’encodage permet de créer des représentations sémantiques des textes, facilitant la recherche et la génération.

Exemples : BERT, RoBERTa, ou d’autres modèles de transformateur utilisés pour l’encodage des textes.

Définition d’un embedding : Un embedding est une représentation sous forme de vecteur d’éléments distincts dans un espace multidimensionnel. Chaque élément est placé dans cet espace de manière à maintenir certaines propriétés ou relations intrinsèques. Autrement dit, les embeddings convertissent des informations complexes et discrètes en un format continu, facilitant ainsi leur traitement par les modèles d’intelligence artificielle.

Module de Récupération d’Information (retriever)

Ce module est chargé de récupérer des passages pertinents à partir d’une grande base de données textuelle. Lorsqu’une requête est envoyée, le retriever recherche les documents ou passages les plus pertinents, souvent à l’aide de techniques de recherche basées sur des embeddings ou des méthodes de correspondance textuelle comme BM25.

Types de Retriever :

- Dense Retriever : Utilise des représentations vectorielles (embeddings) pour trouver des passages similaires en termes de signification.

- Sparse Retriever : Se base sur la fréquence de mots et des méthodes classiques de recherche d’information (comme BM25).

Base de Données de Connaissances

C’est la source d’information où le module de récupération cherche des passages pertinents. Elle peut être constituée d’articles, de documents, de pages web, ou de toute autre collection textuelle.

Lors de la mise en oeuvre du RAG, la base de connaissance est pré traitée afin d’optimiser la récupération des informations. Dans le cas d’utilisation d’un dense retrievers, les données sources sont encodées et les embeddings résultants enregistrés dans une base de données vectorielle.

Mécanisme de Fusion (combiner ou aggregator)

Ce composant analyse les données récupérés et les combine d’une manière qui les rend exploitables par le générateur. Il peut impliquer des techniques de pondération ou de sélection des passages les plus pertinents avant de les fournir au générateur.

Génération de la Réponse

Une fois que les passages pertinents ont été récupérés, ce module génère une réponse en utilisant les informations récupérées. Le générateur est généralement un modèle de langage pré-entraîné (comme GPT) qui peut formuler des réponses cohérentes et informatives en utilisant les passages récupérés comme contexte.

Exemples de Générateurs : GPT-x, BART…

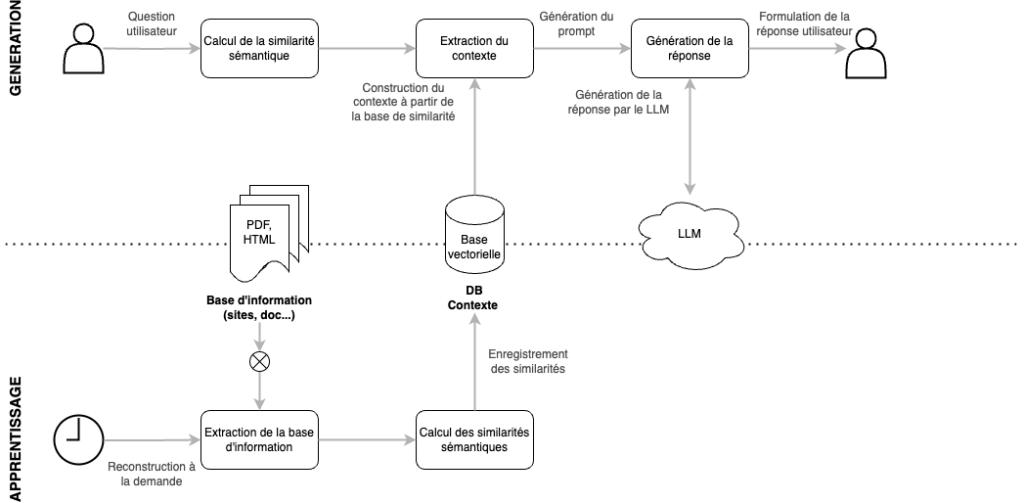

Fonctionnement d’un RAG

Lorsqu’une requête est traitée par un système RAG (Retrieval-Augmented Generation), les différents composants collaborent de manière séquentielle pour fournir une réponse cohérente et informée.

Encodage de la Requête

Action : La requête utilisateur est d’abord encodée en une représentation vectorielle à l’aide du module d’encodage (souvent basé sur un modèle de transformateur comme BERT).

Objectif : Cela permet de capturer la signification sémantique de la requête, rendant ainsi possible la recherche de documents pertinents dans la base de données.

Récupération d’Informations (retrieval)

Action : Le vecteur de la requête est utilisé par le module de récupération d’information pour interroger la base de données de connaissances.

Processus :

- Le retriever identifie et récupère un ensemble de passages ou documents pertinents en fonction de la similarité sémantique avec la requête.

- Le nombre de passages récupérés peut varier, mais en général, plusieurs passages sont sélectionnés pour garantir la couverture du sujet.

Fusion des Passages (combinaison)

Action : Le mécanisme de fusion combine les passages filtrés en une entrée cohérente pour le générateur.

Techniques : Cela peut inclure la concaténation des passages, l’utilisation de mécanismes d’attention pour donner plus de poids aux passages les plus pertinents, ou d’autres techniques pour structurer l’information de manière exploitable.

Objectif : Fournir au générateur un contexte riche et bien organisé qui capture les aspects les plus importants de la requête.

Génération de la Réponse

Action : Le module de génération de texte prend l’entrée combinée et génère une réponse textuelle en utilisant un modèle de langage.

Processus :

- Le générateur utilise le contexte fourni pour formuler une réponse qui est à la fois cohérente et informative.

- La génération peut être influencée par des contraintes spécifiques, telles que la longueur de la réponse ou le style attendu.

En résumé, et avec les éléments décrits précédemment, on peut présenter l’architecture systématique minimale d’un RAG comme suit :

- La base de données vectorielles est d’abord constituée avec les embeddings issus de la base de documents.

- Ensuite, à l’arrivée d’une nouvelle requête, son embedding est calculé, et les données les plus pertinentes sont extraites.

- La requête et les embeddings pertinents sont combinés pour créer un prompt, qui est ensuite transmis à un LLM pour fournir la réponse.

Pistes d’optimisation d’un RAG

L’amélioration des performances d’un système RAG est possible en applicant plusieurs stratégies qui se concentrent sur l’optimisation des différents composants de l’architecture.

Amélioration de la qualité des données (Garbage in, Garbage out)

La qualité du contexte fourni doit être élevée. Les sources de données doivent être nettoyées, en capturant des informations pertinentes et en supprimant les balises inutiles.

Expérimentation de plusieurs stratégies de découpage

Le découpage des textes (chunks) est crucial lors de l’analyse de la base de connaissances. Il est donc nécessaire d’expérimenter différentes tailles de fragments de texte pour maintenir un contexte adéquat. La manière dont le contenu est divisé peut affecter de manière significative les performances du système RAG.

Fine-tuning du LLM

Le LLM peut être affiné sur des tâches spécifiques ou des jeux de données spécialisés pour améliorer sa performance dans des contextes particuliers. Ce fine-tuning permet d’adapter le modèle aux exigences précises de l’application et d’améliorer la pertinence des réponses.

Optimisation des prompts

Les prompts utilisés doivent être affinés afin de s’assurer qu’ils guident efficacement le modèle dans l’utilisation du contexte fourni. Les retours des réponses du LLM peuvent être utilisés pour améliorer de manière itérative la conception des prompts.

Expérimentation avec différents modèles d’embeddings

Il est recommandé d’essayer différents modèles d’embedding pour déterminer lequel fournit la représentation la plus précise des données contextuelles.

Avantages d’un RAG

L’architecture RAG présente de nombreux avantages par rapport à l’utilisation d’un LLM seul. Voici les tops 3 de ces avantages :

- Fiabilité : L’utilisation d’une base de connaissances contrôlée réduit la probabilité d’hallucination et augmente le taux de confiance des utilisateurs.

- Souplesse : La modification de la base de connaissances est simple grâce à l’ajout de documents dans la base vectorielle.

- Efficacité : Le LLM utilisé peut être de taille plus petite que des modèles comme GPT-4, tout en fournissant des résultats pertinents.

Conclusion

Les LLMs ont prouvé leur efficacité exceptionnelle dans le traitement et la réponse à des requêtes d’information complexes, ouvrant de nouveaux horizons dans le domaine de l’intelligence artificielle et de la recherche d’information. L’intégration des architectures RAG dans ces modèles a entraîné une amélioration significative de la précision et de la fiabilité des réponses. Cette avancée résulte principalement d’une gestion dynamique des bases de connaissances, qui agit efficacement contre la propagation de désinformation et la réplication de biais présents dans les données initiales.

Cependant, ces progrès technologiques ne doivent pas occulter les implications plus larges de l’utilisation des LLMs et des RAG, ainsi que de l’IA en général, dans la société. Les risques associés à l’utilisation des données personnelles et la responsabilité des systèmes d’IA en cas d’erreurs sont des sujets qui nécessitent une vigilance accrue. Ces enjeux soulèvent des questions éthiques et légales importantes, requérant une attention particulière et une démarche réfléchie pour intégrer ces technologies avancées de manière responsable dans notre quotidien. En outre, la mise à jour continue et la vérification des données utilisées par ces systèmes est essentielle. Ce processus est indispensable pour non seulement maintenir l’intégrité et la pertinence des réponses fournies par les systèmes basés sur l’IA mais également garantir leur alignement avec les normes éthiques et légales en vigueur.

Pour exploiter pleinement les avancées de l’IA, nous considérons qu’une démarche continue d’exploration, de test et d’évaluation est essentielle, tout en respectant les cadres réglementaires. Ce dialogue entre technologie d’un côté et vigilance et responsabilité de l’autre, définit le chemin vers un futur où l’IA est à la fois puissante et prudente !

Vous aspirez à concevoir ou améliorer un système de recherche d’information sur mesure ? un moteur de recherche plus précis ? un chatbot pertinent ? ou un système de recommandation personnalisé ?

Passez à l’Action et Trouvez l’Expertise Dont Vous Avez Besoin avec Eurelis !

Eurelis, Votre Expert en Intelligence Artificielle vous accompagne étape par étape dans la réalisation de vos projets les plus ambitieux !

Embarquez dans cette aventure et faites évaluer votre projet par un expert Eurelis ! 🚀

Si vous avez manqué le début…

- Article 0 : Transformer l’information en Innovation. Un voyage à travers les Évolutions des Systèmes de Recherche d’Information.

- Article 1 : Systèmes de Recherche d’Information: De l’Indexation à la Compréhension !.

- Article 2 : Compréhension Structurée – L’Évolution des Bases de Données et de la recherche !

- Article 3 : Recherche sémantique – Les Bases de Données Vectorielles, Révolutionnaires !

- Article 4 : Révolutions de l’IA – Avancées dans les Modèles de Langage